Le site d’information et d’enquête Mediapart publie les révélations depuis l’usine à “intelligence artificielle artificielle” de Siri, signées Jerome Hourdeaux. Le journaliste donne la parole aux micro-travailleurs français travaillant depuis le siège de Cork en Irlande d’un sous-traitant du géant de Cupertino, et met la main sur les documents qui attestent l’étendue des abus d’Apple. J’ai été interviewé dans le cadre de cette enquête et j’ai pu apporter mon éclairage à la publication de ces sources inédites.

Par-delà les risques psychosociaux qu’encourent les micro-travailleurs (isolement, TSPT, perte de sens), il y a un problème évident en termes de violation systématique de la vie privée des usagers des produits Apple. L’entreprise a depuis promis de mettre fin à ces pratiques. Crédible ? Pas vraiment, à mon avis.

La partie vraiment passionnante de l’enquête de Mediapart est la plongée dans le fonctionnement concret du micro-travail. Ça rassemble à quoi une micro-tâche de retranscription et d’annotation de conversations captées par une IA ? Comment se structure le workflow de Siri ?

A cette révélation s’en ajoute une autre, celle-ci des plus inquiétantes. Les micro-travailleurs recrutés par Apple ne se limitent pas à retranscrire des phrases anodines que n’importe qui pourrait prononcer. Ils gèrent des données à caractère personnel qui identifient les usagers, lesquels font référence dans leurs conversations à noms, adresses, situations souvent sensibles. De surcroît, pour vérifier que Siri aie bien répondu aux requêtes formulées par les usagers, Apple donne à ses micro-travailleurs accès à tous leurs fichiers personnels via une fonctionnalité qui, selon Mediapart, s’appelle user data browser.

L’usage de ces données n’est pas restreint ni discret, puisque les assistants virtuels comme Siri ont besoin de millions d’exemples pour apprendre à interpréter une simple requête. Leur apprentissage machine nécessite la mise sur écoute systématique et massive des usagers. Ce n’est pas un accident ni le problème de la seule Apple.

J’ai eu l’occasion de l’affirmer ailleurs, et je le répète dans l’article de Mediapart : tous les GAFAM ont désormais été démasqués. Ils ont menti à propos du respect de la vie privée de leurs usagers, mais ils ont surtout menti sur l’artificialité de leurs intelligences artificielles.

Assistant vocal d’Apple: le calvaire des salariés

PAR JÉRÔME HOURDEAUX

ARTICLE PUBLIÉ LE SAMEDI 31 AOÛT 2019

Assistant vocal d’Apple: le calvaire des salariés

À la fin du mois de juillet, TheGuardian et El País révélaient que des centaines de personnes étaient chargées d’écouter les conversations d’utilisateurs de Siri, l’assistant vocal d’Apple, afin de corriger ses résultats. Après avoir suspendu le programme qui reprendra à l’automne, la société vient d’annoncer le licenciement de 300 salariés.

Alors que, acculé par les révélations sur l’écoute des utilisateurs de Siri, Apple vient de mettre à la porte plusieurs centaines de salariés, Mediapart a pu recueillir les témoignages de plusieurs d’entre eux et consulter des documents détaillant le travail de ces employés, chargés d’écouter les utilisateurs.

Au total, au moins 300 personnes travaillant pour des sous-traitants d’Apple à Cork, en Irlande, se sont vu notifier la fin de leur contrat vendredi dernier, rapporte mercredi 28 août The Guardian.

Cette annonce n’a pas vraiment été une surprise pour les salariés concernés. Depuis le 2 août, nombre d’entre eux avaient été placés en chômage technique après la révélation, par The Guardian et El País, de la nature réelle de leur travail : écouter les utilisateurs d’Apple parler à Siri. Cette intelligence artificielle, embarquée sur l’ensemble des appareils vendus par la marque à la pomme, permet d’activer une application, d’écouter de la musique, de faire une recherche sur Internet ou encore d’appeler un contact, simplement en donnant un ordre oral.

Les articles du Guardian et d’El País n’étaient pourtant pas en eux-mêmes des scoops. Plusieurs chercheurs avaient déjà expliqué que les intelligences artificielles le sont beaucoup moins que ce que leurs concepteurs prétendent. Incapables de réellement « apprendre » par eux-mêmes, les algorithmes ont besoin de centaines de milliers d’exemples, fournis par des êtres humains.

Les deux quotidiens rapportaient en revanche les témoignages inédits d’anciens salariés de sous- traitants d’Apple ayant passé leurs journées à écouter des conversations de clients et à noter la réponse apportée par Siri. De plus, révélaient-ils, les différents appareils sur lesquels est embarqué l’assistant vocal ont une fâcheuse tendance à activer celui-ci à tout bout de champ.

Les salariés chargés d’écouter les extraits sonores enregistrés par Siri tombaient ainsi régulièrement sur des échanges particulièrement privés, comme lors de relations sexuelles ou encore lors de ce qui semblait être un trafic de drogue. En réaction, Apple avait annoncé la suspension de programmes d’amélioration de Siri, le temps de revoir ceux-ci et de les reprendre, sous une forme modifiée, à l’automne prochain.

Depuis, Mediapart a également recueilli les témoignages de plusieurs ex-salariés ayant travaillé dans les locaux de GlobeTech, l’une des deux principales sociétés travaillant pour Apple à Cork (l’autre étant Lionbridge). Ceux-ci confirment les informations du Guardian et d’El País et donnent des détails supplémentaires.

Les centaines de personnes travaillant pour Globetech et Lionbridge étaient affectées à de multiples « projets » correspondant aux différentes phases de vérification et de notation de Siri. Ces différentes tâches nécessitaient des compétences et des niveaux d’accréditation différenciés permettant, pour certaines d’entre elles, d’accéder aux données personnelles contenues dans l’appareil de l’usager.

Chaque salarié étant soumis à une clause de confidentialité, il est très difficile de savoir à quoi correspond exactement chacun de ses projets. Mais plusieurs documents internes et témoignages d’ex- salariés recueillis par Mediapart permettent d’avoir une idée assez précise du rôle des humains au cœur du fonctionnement de l’intelligence artificielle et de leurs conditions de travail.

Les salariés travaillant directement sur Siri sont classés en deux principales catégories. Il y a tout d’abord les « language analysts », qui travaillent sur les « bulk data », les données brutes, c’est-à-dire les extraits audio livrés sans autre information.

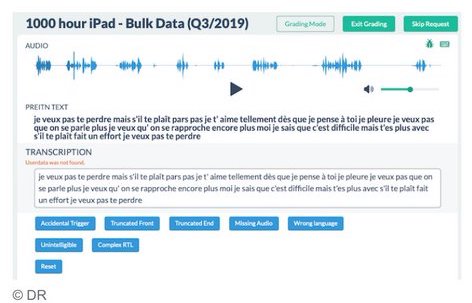

La tâche de base correspond aux programmes « 1.000 hours » (1 000 heures) et se décline au sein de projets spécifiques en fonction de l’appareil : « 1.000 hours iPhone », « 1.000 hours iPad », « 1.000 hours CarPlay », etc. Le salarié, connecté à une interface sur un réseau interne d’Apple, a accès à l’enregistrement audio et, dessous, la transcription automatique qui a été faite par l’algorithme. Il doit se contenter d’écouter la séquence, appelée « itération », et de corriger les éventuelles fautes de retranscription.

Le nombre d’itérations nécessaires au bon fonctionnement de Siri est impressionnant. Dans les documents consultés par Mediapart, un tableau d’objectifs trimestriel donne le chiffre de 609 309 extraits audio pour les clients francophones, 874 778 pour les Chinois, ou encore 716 388 pour les Japonais. Et ce, uniquement sur le troisième trimestre 2019 et pour l’iPad. S’ensuit, pour les employés, un rythme effréné afin d’atteindre un quota quotidien fixé à 1 300 itérations par jour.

L’autre catégorie d’employés correspond aux « data analysts » qui, eux, ont accès à certaines données personnelles des utilisateurs. Apple avait pourtant affirmé que ses salariés n’avaient pas les moyens d’identifier les personnes écoutées, notamment parce qu’ils ne disposaient pas de l’« user ID », l’identifiant.

C’est en partie vrai. Le nom de l’utilisateur ou son numéro n’apparaissent effectivement pas. Mais un petit menu intégré à l’interface d’Apple, le user data browser, permet d’effectuer des recherches parmi les données stockées dans l’appareil. Cette fonctionnalité est principalement intégrée à l’outil de notation de Siri, le Siri results widget (SRW).

Assistant vocal d’Apple: le calvaire des salariés

Celui-ci présente, en haut, l’extrait sonore et, en dessous à gauche, la réponse apportée par Siri à la requête. À droite, une série de questions permet de noter celle-ci. Et en dessous, le user data browser permet de fouiller dans les données de l’appareil pour vérifier que Siri a utilisé les bonnes informations.

Comme l’explique l’un des documents, « les données d’utilisateur peuvent être utiles pour comprendre l’intention de l’utilisateur. Par exemple, si l’utilisateur dit : “Montre coucher de soleil horizontal”, cela peut être dur à comprendre. Toutefois, si l’utilisateur a un album photo appelé “Couchers de soleil horizontaux”, ce que l’utilisateur voulait devient clair ».

Concernant les conditions de travail, les salariés des sous-traitants d’Apple sont un peu mieux lotis que beaucoup d’autres micro-travailleurs, tels que ceux décrits notamment par le sociologue Antonio Casilli, auteur du livre En attendant les robots (Seuil, janvier 2019) et membre du projet DipLab (Digital Platform Labor), à l’origine du rapport « Le micro-travail en France », sorti en avril 2019.

Ce nouveau sous-prolétariat numérique, ces « tâcherons du Web », travaillent bien souvent de chez eux, via des plateformes intermédiaires, et ne connaissent souvent même pas l’identité du commanditaire. Ils sont rémunérés à la tâche, le plus souvent quelques centimes d’euros.

À GlobeTech, les salariés disposent d’un contrat de travail de droit irlandais, avec un salaire mensuel d’environ 2 000 euros brut par mois, pour des journées de 7 h 30, pause déjeuner déduite, avec deux pauses de 15 minutes. Ils travaillent dans des locaux spécifiques d’où ils se connectent à l’interface d’Apple via un réseau sécurisé.

Les conditions de travail y sont strictes, et souvent mal vécues par les salariés. « Le pire, c’est le côté répétitif, les itérations qui reviennent constamment, du style “mets l’alarme à telle heure”, explique Antoine*, un des anciens salariés que Mediapart a rencontrés. Les gens étaient tous surdiplômés, des bac + 3 à bac + 5. Tout le monde s’ennuyait. La plupart des gens s’en allaient le plus tôt possible, dès qu’ils avaient fini leur quota journalier d’itérations. Je crois que personne ne reste plus de six mois. Même nos supérieurs avaient l’air de détester leur travail. »

« De plus, poursuit le jeune homme, on était hyper fliqués. Quand on ne faisait pas d’itération pendant plus de six minutes, on était considéré en pause. Il fallait envoyer chaque soir par mail le nombre d’itérations que l’on avait faites durant la journée. »« On pouvait être viré du jour au lendemain, confirme Gaël*, un autre ex-salarié. Le soir, votre superviseur pouvait venir vous voir pour vous dire : t’as pas fait tes stats aujourd’hui, tu pars. »

Beaucoup de salariés ont mal vécu le fait d’être les témoins de la vie privée des utilisateurs. Une bonne partie des requêtes concernent des ordres assez classiques, comme appeler un contact. « Le plus drôle que j’ai eu, c’est un “appel Frank Riester” », se souvient Antoine.

Mais certains se révèlent particulièrement intrusifs.

« Beaucoup de gens dictent leurs textos. Et on a donc beaucoup de “sextos” », raconte Antoine. Il y a également les cas de demande de recherche relative à des maladies par exemple. « On entend aussi beaucoup de voix d’enfant. On ne leur a pas demandé leur avis,

à eux ! », s’indigne Gaël, qui se souvient d’une voix enfantine demandant : « Dis Siri, tu peux me montrer une photo de vrai zizi ? »

Il y a également les nombreuses personnes qui utilisent Siri comme dictaphone, afin d’enregistrer des mémos vocaux. Antoine et Gaël sont ainsi tous deux tombés à de nombreuses reprises sur des extraits de professeurs, enregistrant leurs avis de conseils de classe.

Enfin, il y a les enregistrements accidentels, provoqués par un déclenchement involontaire de Siri. Car l’assistante vocale semble particulièrement sensible. « Ça s’active à tout bout de champ, confirme Antoine. J’ai remarqué que ça marchait notamment avec les phrases des autres assistants vocaux, par exemple si vous dites “OK Google”. »

Lorsqu’un salarié tombait sur un de ces enregistrements, il devait l’écouter et le signaler en cliquant sur un bouton « accidental trigger ». « C’était tout simplement le bouton sur lequel on appuyait le plus, se souvient Antoine. On pouvait entendre de tout. Ça pouvait être la musique d’une voiture pendant plusieurs minutes ou deux ados se racontant leurs drames. » Gaël, lui aussi, est tombé à plusieurs reprises sur des disputes amoureuses, des confessions intimes…

Parfois, le malaise ressenti par le salarié se transforme en traumatisme. Certains salariés peuvent être confrontés à des enregistrements dévoilant des pratiques illégales ou des situations de violence. « Je me souviens un jour d’une fille qui disait à sa copine, a priori à propos de son petit copain, un truc du style : “il est dangereux, il faut le faire enfermer”. Dans ces cas-là, on se sait pas quoi faire, on ne sait pas s’il y a réellement danger. » Gaël, de son côté, se souvient d’un enregistrement dans lequel un homme tient des propos explicitement pédophiles. « Ça m’a mis hors de moi, se souvient-il. Avons-nous un devoir moral à partir du moment où on surveille ? Est-ce qu’il n’y a pas un délit de complicité ? »

En page d’accueil du portail d’aide mis à la disposition des salariés par Apple, un message les prévient qu’ils peuvent être confrontés à « des propos vulgaires, des thèmes violents, pornographiques ou des sujets criminels » et les incite à contacter leur supérieur si besoin. Pourtant, dans la pratique, les salariés n’ont aucune information sur ce qui arrive par la suite.

« Ce genre de traumatisme est assez courant, explique Antonio Casilli. Il arrive même que certains travailleurs souffrent du syndrome de stress posttraumatique, notamment chez ceux chargés de la modération des commentaires. Des modérateurs de Microsoft et de Facebook ont déjà poursuivi leur employeur après avoir été frappés par ce syndrome. Dans le contexte des correcteurs de Siri, poursuit le sociologue, il y a un facteur supplémentaire qui joue : la difficulté de contextualisation. Ils sont confrontés à des extraits de discussions, des propos isolés, totalement déracinés du contexte général. Ils ne peuvent pas savoir s’il s’agit d’une provocation ou d’une exagération. Cela peut être plus perturbant que s’ils étaient présents physiquement. »

Dans ses travaux, Antonio Casilli a démontré à quel point les micro-travailleurs étaient indispensables au bon fonctionnement des intelligences artificielles. Dans ce cas, quelles mesures prendra Apple ? La marque à la pomme a annoncé au Guardian que le programme de notations de Siri reprendrait à l’automne, avec quelques modifications. Les utilisateurs auront notamment la possibilité de préciser qu’ils refusent d’être écoutés et les personnes chargées d’écouter les extraits sonores seront directement employées par Apple.

Antonio Casilli prend ces annonces « avec beaucoup de méfiance ». « Le travail de ces personnes est fondamental pour le fonctionnement d’un assistant vocal, rappelle-t-il. L’intelligence artificielle a besoin d’être entraînée et vérifiée. Sinon, elle ne marche pas. Ils vont donc devoir inventer une nouvelle manière de faire cet entraînement et cette vérification.

La solution consistant à internaliser ces tâches permettrait notamment d’imposer des contraintes de confidentialité accrue. Mais ça irait tout simplement à l’encontre des principes de gestion d’Apple. Une autre solution serait de morceler encore plus les tâches d’entraînement et de vérification et de les confier à des centres de gestion dans des pays tiers, poursuit le sociologue. Il y a tout de même eu une vague de révélations ces derniers mois, avec plusieurs travailleurs qui se sont transformés en lanceurs d’alerte. Et il semblerait que la plupart d’entre eux soient originaires de pays de l’Union européenne, où les législations sont plus protectrices qu’ailleurs. On peut imaginer qu’Apple cherche à installer ses centres de gestion dans des pays ayant une législation moins clémente. »

Gaël, lui aussi, est convaincu que le programme reprendra sous peu, peut-être en interne. « Ils vont se contenter de modifier les conditions générales d’utilisation pour y inclure le fait que ce que vous dites à Siri peut être écouté. Les gens vont signer et ça reprendra », prédit le jeune homme. « C’est, hélas, très possible, acquiesce Antonio Casilli. Nous sommes tous les esclaves de ce consentement forcé que sont les CGU. Ils sont totalement capables d’y mettre ce qui était encore inimaginable hier. »

Les révélations de ces derniers mois marquent cependant un tournant incontestable. Le 13 août, c’est Facebook qui admettait, lui aussi, écouter les conversations des utilisateurs des fonctions audio de son service Messenger et annonçait leur suspension. Apple, de son côté, a présenté jeudi 29 août ses excuses à ses clients écoutés.

« Tous les Gafam ont désormais été démasqués, constate Antonio Casilli. Il y a encore un an, si je disais dans une conférence que des travailleurs écoutent ce que l’on dit à un assistant vocal, c’était une “educated guess”, une supposition éclairée, une conséquence logique de ce que j’avais pu comprendre de leur fonctionnement lors de mes recherches. »

« Depuis, il y a eu une avalanche de témoignages qui montrent que non seulement il y a des enregistrements sauvages, mais également que ces assistants vocaux sont extrêmement défectueux, poursuit le sociologue. Quand on voit des taux de précision de 90 %, on peut se dire que c’est déjà pas mal, mais ça veut dire tout de même que quand vous demandez votre chemin, une fois sur dix, l’algorithme vous donnera le mauvais. C’est tout de même problématique. Apple a donc doublement menti : en disant qu’ils n’enregistraient pas les gens, et en leur affirmant que Siri fonctionne. »